- Дата-центр без потерь электроэнергии

- Экономия на охлаждении

- Воздух с улицы

- Охлаждение с помощью воды

- Традиционный подход

- Экономия на ИТ-оборудовании

- Модульный принцип

- Выше производительность с прежним бюджетом мощности

- Качественное охлаждение в новых формфакторах

- Статистические данные по рынку услуг ЦОД в Казахстане

- Выгоднее использовать высокоплотные стойки

- Выгоднее строить отказоустойчивые ЦОДы

- Выгоднее строить большие ЦОДы

- Выгоднее строить большие энергоэффективные ЦОДы с уровнем отказоустойчивости Tier III и большим количеством высокоплотных стоек.

Дата-центр без потерь электроэнергии

Высокие счета за электроэнергию являются главной статьей расходов для владельцев дата-центров. Современные центры обработки данных (ЦОД) потребляют около 1–2% электричества, вырабатываемого в мире. «Мозгом» дата-центра, который выполняет полезные вычисления, являются серверы, однако на них приходится лишь треть энергии, подведенной к площадке.

Наиболее

«прожорливой» является система холодоснабжения ЦОД, реализованная по наиболее

распространенной и классической на сегодняшний день схеме – на чиллерах или прецизионных кондиционерах с прямым расширением (DX

-системы). При таком подходе на охлаждение приходится 45% энергозатрат. Без систем контроля температуры обойтись нельзя, так как в процессе работы

вычислительные ядра серверов выделяют много тепла, и его своевременный отвод

необходимо обеспечить, чтобы ИТ-оборудование не вышли из строя в результате

перегрева. Еще не менее 12% энергии в ЦОД теряется при распределении в электросетях и в источниках бесперебойного питания (ИБП). Кроме того, часть

электроэнергии уходит на работу автоматизированной систему диспетчерского

управления (АСДУ).

Энергопотребление ЦОД до внедрения фрикулинга и FCC

Экономия на охлаждении

Поскольку высокие операционные издержки, в первую очередь, обусловлены потребностями

инженерных систем, одной из главных технических характеристик современных ЦОД

является коэффициент энергоэффективности PUE, который равен отношению общего

энергопотребления ЦОД к потребностям ИТ-оборудования. Этот показатель отражает,

насколько много энергии тратится на работу обслуживающих инженерных комплексов.

Технологии, используемые для экономии электроэнергии при охлаждении:

- системы полного свободного охлаждения FFC (full free-cooling system)

- чиллеры с функцией свободного охлаждения

- адиабатическое охлаждение

- технология разделения холодных и горячих коридоров и оптимизация воздушных потоков

- двигатели с электронными коммутаторами и спиральные компрессоры

Воздух с улицы

Один

из наиболее распространенных подходов – применение оборудования с функцией «фрикулинга»,

то есть использование естественного холодного наружного воздуха.

Россия обладает уникальными климатическими возможностями для реализации этого подхода.

Благодаря длительному холодному периоду в течение до полугода, чиллеры с функцией

свободного охлаждения («фрикулинг») могут обеспечивать холодоснабжение ЦОД без включения компрессора – наиболее энергопотребляющего элемента системы, работа

которого, в зависимости от конфигурации и нагрузки системы, может потребоваться

только выше 5 С 0. Как показывает практика, применение чиллеров с функцией свободного охлаждения позволяет экономить до 40% электроэнергии по сравнению решениями без данной функции. Энергоэффективность (PUE

среднегодовой) для России в таких решениях может достигать порядка 1,3 -1,4 в зависимости от конфигурации решения, климатической зоны и принятых

температурных параметров в ЦОД.

Еще более экономичными являются системы FFC (полного свободного охлаждения). В основе данного решения заложен принцип теплообмена между холодным наружным

воздухом и воздухом, циркулирующем в ЦОД, который происходит через промежуточный

роторный теплообменник (рекуператор). Таким образом, уличный воздух не поступает непосредственно в ЦОД, а через роторный теплообменник охлаждает

воздух внутри до требуемой температуры, регулирование температуры в дата-центре

при этом производится изменением скорости вращения роторного теплообменника.

В России данную технологию активно анедряет фирма Ayaks Engineering, которая обладает

собственным запатентованным решением. Данная схема позволяет использовать для охлаждения оборудования в ЦОД уличный воздух до +22 С 0, при более

высоких температурах в состав решения включаются контуры адиабатического

охлаждения и компрессорный фреоновый модуль DX. По

данным Ayaks Engineering, применение данного решения обеспечивает экономию

электроэнергии на охлаждение ЦОД до 60 % относительно классических систем и среднегодовой PUE до 1,16.

Схема установки FFC (c сайта Ayaks Engineering)

Энергопотребление в ЦОД c функцией фрикулинга и FCC

Охлаждение с помощью воды

Еще один способ охлаждения воздуха в ЦОД, уже упомянутый ранее в решениях Ayaks Engineering, позволяющий

минимизировать расходы на энергию, получил название адиабатического охлаждения. В этом случае для снижения температуры используется вода, которая обладает

большой теплоемкостью. Принцип действия систем адиабатического охлаждения

состоит в распылении воды в виде мельчайших капель, при этом испарение происходит

с потреблением тепла и соответствующим понижением температуры воздуха.

Решения

с косвенным адиабатическим охлаждением есть у всех ведущих производителей

климатического оборудования и в общем случае представляет собой систему

трубопроводов высокого давления с распылительными форсунками, насосные

агрегаты, станцию водоподготовки и автоматическую систему управления. Наибольший

эффект адиабатическое охлаждение будет давать в сухом теплом климате, при повышении

влажности наружного воздуха (более 60%), эффективность такого подхода начинает снижаться,

и при влажности наружного воздуха близкой к 100% (например в дождь) эта

технология перестает работать. Экономия электроэнергии от применения систем

полного свободного охлаждения совместно с адиабатическим охлаждением по отношению к классическим системам холодоснабжения на чиллерах или DX-системам

может достигать 60% -90% в зависимости от региона расположения ЦОД, однако в данных системах появляется еще одна статья расходов – вода, и затраты на нее

также надо учитывать.

Традиционный подход

При сохранении традиционных систем охлаждения, тем не менее, также существует

несколько способов повысить эффективность инженерных систем и снизить PUE. Один из подходов заключается в изоляции горячих и холодных коридоров. По оценке

компании Schneider Electric, изоляция горячего коридора вместо холодного

поможет ежегодно экономить около 43% энергии, используемой системой охлаждения,

что соответствует снижению показателя PUE на 15%. Также, независимо от выбранной технологии необходимо не забывать о том, что все решения по энергоэффективности могут стать бесполезными, если в серверных шкафах не будет

решен вопрос об исключении смешивания потоков горячего и охлажденного воздуха. Для этого необходимо устанавливать заглушки на свободных от оборудования юнитах в серверном шкафу.

Другой распространенный вариант экономии в системах охлаждения представляют собой применение вентиляционного оборудования и кондиционеров с ЕС-двигателями (электронно-коммутируемый двигатель) и спиральных

компрессоров Scroll Digital™ в чиллерах. Основное достоинство этих решений в возможности регулировать свою производительность в широком диапазоне, в зависимости от текущей нагрузки, что обеспечивает до 30% экономии

электроэнергии. Собственно, применение такого оборудования (с эффективным

регулированием производительности) стало уже практически стандартом при построении любого ЦОД.

Экономия на ИТ-оборудовании

Вторая крупная статья расходов на энергию связана с потребностями непосредственно

ИТ-оборудования. Известно, что вычислительные мощности дата-центр очень редко

бывают загружены максимально, то есть получается, что часть ИТ-оборудования

всегда работает «вхолостую». Как заставить инфраструктуру ЦОД работать более

эффективно?

Прежде всего, оптимизировать эту строку бюджета можно за счет более эффективного

использования имеющихся серверов за счет внедрения средств виртуализации,

которые позволяют представить физический сервер в виде виртуальных машин. Ранее, под каждую задачу/клиента дата-центр выделял отдельный сервер, при этом

загрузка большую часть времени могла быть низкой. После виртуализации клиенты

пользуются виртуальными машинами, которые могут работать на одном физическом

сервере, тем самым уплотняя загрузку полезных мощностей, при этом простаивающие

ресурсы становится возможным временно отключить от питания.

Модульный принцип

Выше были рассмотрены технологии, правильное применение которых может повысить

энергоэффективность ЦОД (PUE) по отдельным

инженерным и ИТ-системам. Но есть еще один подход к повышению PU более высокого уровня, который распространяется на все

системы дата-центра. Он основан на модульном принципе построения ЦОД. Данный

подход позволяет более четко соблюсти баланс между ИТ-нагрузкой и обслуживающей

ее инженерной инфраструктурой, что, в конечном счете, отражается на энергоэффективности. Модульный принцип построения и модульные ЦОДы можно встретить

на рынке в двух вариантах.

Во-первых, могут быть использованы стандартизированные модули-контейнеры с предустановленным производителем холодильными, электросиловыми установками, конструктивами

серверных стоек и другим технологическим оборудованием. Такой подход позволяет

достаточно быстро построить ЦОД необходимой мощности, собирая его из стандартных «кубиков». Подобные решения есть у таких крупных производителей

оборудования для ЦОД как Schneider Electric, Emerson, Huawei и т. Такой способ

строительства ЦОД возможен как в «чистом поле», так и при приспособлении

(реконструкции) для ЦОД какого-либо здания.

Второй вариант предполагает использование инженерного оборудования любого

производителя, а модульный принцип реализуется архитектурно-планировочными и инженерно-технологическими решениями. При этом серверный зал выделяется в отдельный автономный модуль, который имеет полный набор необходимых инженерных

систем. По мере роста потребностей этот модуль тиражируется. Данный способ

строительства ЦОД, как правило, применяется при новом строительстве в «чистом поле».

Различие этих вариантов, по сути, касается в основном больше способа возведения и типа

строительного конструктива здания ЦОД, в первом варианте — это готовые модули,

произведенные на заводе-изготовителе и собранные воедино на площадке, во втором

варианте ЦОД может быть реализован и как капитальное строение, рассчитанное на 50-летний срок эксплуатации.

Самое важное, что обеспечивает модульный подход – это соблюдение баланса между ИТ-нагрузкой

и инженерной инфраструктурой и возможность быстрого наращивания и масштабирования стандартизованными модулями.

Европейский технологический гигант Siemens продемонстрировал решения на основе систем искусственного интеллекта, помогающие снизить энергопотребление в дата-центрах балтийских государств. В частности, новые разработки применили в ЦОД, расположенном в эстонском Таллине, оператором которого является компания Greenergy.

Если в среднем по отрасли коэффициент эффективности использования энергии (PUE) для ЦОД составляет 1,6, то Greenergy удалось снизить его в своём проекте до 1,2. По словам главы подразделения решений и сервисов в Siemens Smart Infrastructure Дейва Хоппинга (Dave Hopping), по мере того, как во всём мире растёт спрос на услуги дата-центров, цифровые инструменты будут играть ключевую роль в компенсации негативного воздействия на окружающую среду в процессе обработки данных.

Источник изображения: Greenergy

Комбинация программного обеспечения для управления зданиями, энергетикой и охлаждением объекта позволяет Greenergy использовать единую платформу для мониторинга и контроля распределения энергии, а система машинного обучения помогает оптимизировать охлаждение. Некоторые из задействованных технологий разработаны американской Vigilent (бывшей Federspiel Controls), сотрудничавшей с Siemens в создании систем ИИ для охлаждения ЦОД с 2018 года — технологии компании используются и в других крупных проектах, включая решения Schneider Electric или, например, Hitachi.

По словам представителя Greenergy новый комплекс соответствует самым высоким международным стандартам и обеспечивает на 25 % лучшую энергоэффективность, чем в среднем по рынку.

Важным преимуществом является система динамического охлаждения таллинского ЦОД — он считается «крупнейшим на Балтике», занимающим площадь более 1400 м2. Центр работает на возобновляемой энергии и является первым из трёх ЦОД, постройка которых предусмотрена на территории таллинского кампуса.

Известно, что для мониторинга энергоэффективности Siemens обеспечила проект кастомизированной системой энергораспределения, интегрированной в платформу управления зданиями Desigo CC. Помимо этого используется самое передовое энергетическое оборудование, выпускаемое как самой Siemens, так и её партнёрами.

Современные ЦОДы способны обеспечить PUE на уровне 1,5 или ниже — это стало возможным за счет целого ряда улучшений.

Центры обработки данных — это фундамент цифровой экономики, однако для их работы требуется огромное количество энергии. Стараясь сделать цифровую трансформацию более экологичной, необходимо в первую очередь правильно проектировать ЦОДы и использовать энергоэффективные компоненты ИТ-инфраструктуры. Ключевую роль в решении этой задачи играют SSD.

В последние годы заметно вырос спрос на центры обработки данных, что можно объяснить цифровой трансформацией и растущей популярностью облачных сервисов. Соответственно, количество ЦОДов растет, а существующие объекты продолжают расширяться. Едва ли эта тенденция пойдет на спад, ведь «Интернет вещей» тоже стремительно развивается, в результате чего в ближайшие годы мы можем ожидать взрывного роста объема данных, для обработки которых потребуется еще более продвинутая цифровая инфраструктура.

Впрочем, судя по рекордно низким показателям PUE (power usage effectiveness), ЦОДы стали заметно эффективнее: этот коэффициент обозначает общий объем энергопотребления по отношению к энергетической потребности ИТ-инфраструктуры. Другими словами, насколько эффективна базовая инфраструктура, в том числе системы охлаждения и насосы, ИБП и аккумуляторы. Современные ЦОДы способны обеспечить PUE на уровне 1,5 или ниже — это стало возможным за счет целого ряда улучшений, в том числе оптимизации систем охлаждения, широкого применения вторичного тепла, продвинутых ИТ-компонентов, которые больше не требуют экстремального охлаждения помещений, а также правильно настроенных трансформаторов тока. В современных ЦОДах более двух третей энергии потребляют ИТ-системы.

Таким образом, хотя 10 млрд киловатт-часов из упомянутых 16 составляют львиную долю потребления в центрах обработки данных в 2020 году, теперь оборудование куда совершеннее: по данным Borderstep Institute, с 2010 года энергопотребление в ЦОДах выросло на 75%, а производительность – в восемь раз. Чтобы добиться этого, производители ИТ-оборудования активно вкладывались в техническую модернизацию. А кроме того, ужесточились правовые нормы в этой сфере — например, недавний регламент ЕС 2019/424 устанавливает минимальный уровень эффективности для источников питания в серверах и системах хранения.

Выше производительность с прежним бюджетом мощности

Серверы, системы хранения и сетевые компоненты в ЦОДах работают в комплексе, поэтому зависят друг от друга в плане затрат мощности. Растущие объемы данных приводят к увеличению энергопотребления не только хранилищ, но также серверов и сети, ведь данные необходимо передавать и обрабатывать. Работа над сбережением энергии исключительно в системах хранения возможна, только когда речь идет об архивных данных, однако усложняется их регулярной валидацией, при которой задействуются остальные ИТ-компоненты. Поэтому операторы ЦОДов выделяют бюджет мощности на стойку, который распределяется между отдельными потребителями.

Однако, если речь идет о развертываниях с действительно высокими потребностями в памяти, очень важно вдумчиво подойти к планированию эффективности хранилищ, ведь каждый ватт, не использованный в эксплуатации, будет доступен для других систем в стойке. За счет энергоэффективного хранилища стойка обеспечит более высокий уровень производительности с прежним бюджетом мощности.

Теоретически SSD требуют меньше энергии, чем жесткие диски, ведь они не имеют механических компонентов. Однако, поскольку на SSD возлагаются определенные операции, например управление ячейками памяти и обновление состояний памяти для обеспечения готовности к использованию, во время простоя они потребляют столько же энергии, сколько и жесткие диски, а вот в режиме эксплуатации – наоборот, гораздо больше. Например, если текущий PCIe-накопитель четвертого поколения от KIOXIA в активном состоянии потребляет до 21 Вт, то жесткий диск корпоративного уровня с 7200 оборотами в минуту требует вдвое меньше.

Впрочем, здесь не учитывается производительность этих носителей. Расхода 8–12 Вт жесткого диска хватает лишь на несколько сотен IOPS, в то время как SSD достигает показателя 1,4 млн IOPS. Это означает, что в активном состоянии последний гораздо энергоэффективнее.

Более того, SSD предоставляют данные гораздо быстрее, поэтому для обработки определенной рабочей нагрузки им нужно заметно меньше времени при максимальном расходе энергии. Например, KIOXIA CM6 передает данные на скорости 6900 Мбайт/c, то есть на файл объемом 500 Гбайт уходит 72 секунды: при максимальном расходе мощности в 21 Вт это соответствует 0,4 Вт∙ч, тогда как фактическое энергопотребление для последовательных операций чтения несколько ниже. С другой стороны, жесткому диску на передачу 500 Гбайт потребуется около 28 минут: при расходе 9 Вт это 4 ватт-часа. Таким образом, SSD в десять раз более энергоэффективен.

Однако по-настоящему серьезным преимуществом является прямой доступ. Если стандартный жесткий диск корпоративного уровня обеспечивает около 250 IOPS, то SSD от KIOXIA достигает 1,4 млн IOPS — в 2400 раз выше.

Качественное охлаждение в новых формфакторах

Благодаря своей высокой производительности SSD заметно эффективнее и в плане охлаждения. Подтверждено, что SSD новейшего поколения с поддержкой PCIe имеет более высокие требования к охлаждению во время эксплуатации при полной нагрузке, чем жесткий диск за тот же период времени. Однако для передачи файла или определенного количества IOPS жесткому диску понадобится гораздо больше времени, что означает более продолжительный период охлаждения и более высокие требования к системе охлаждения.

Статистические данные по рынку услуг ЦОД в Казахстане

Для сферы строительства центров обработки данных характерен ряд противоречий. Приведу некоторые из них:

- Высокий спрос подтверждается следующим статистическим фактом: согласно IKS Media, объем выручки от услуг коммерческих ЦОД в Казахстане вырос на 36% в 2021 году, по сравнению с 2019 годом. И это при том, что доходы от их услуг не превышают 3,5% совокупных доходов от ИТ-услуг. То есть, в сравнении с другими сферами ИТ, бизнес коммерческих ЦОД не выглядит инвестиционно-привлекательными по причине невысокой прибыльности. Зато, прибыль от коммерческих датацентров стабильная — средний срок эксплуатации ЦОД может достигать десяти и более лет;

- О росте инвестиций в рынок строительства ЦОД свидетельствуют растущие объемы рынка облачных услуг. Рост, в среднем, на 38% из года в год в тенговом выражении. Здесь мы наблюдаем «динамичный рост без взрывного эффекта». И пока главным инвестором строительства ЦОДов в Казахстане остается государство, но правила игры постепенно меняются и финансовые институты разрабатывают различные инструменты для частных инвесторов (фонды, облигации, хеджирование и так далее);

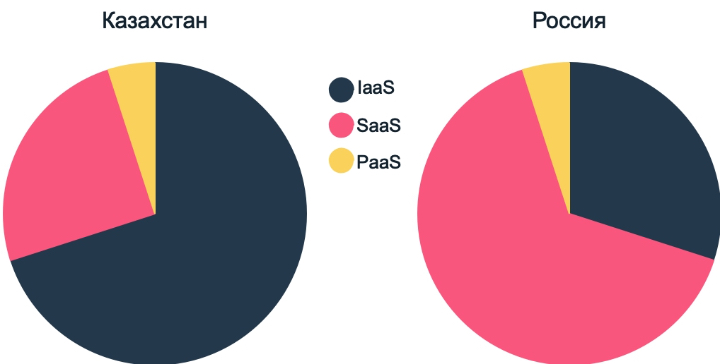

- И еще одно интересно наблюдение: в структуре облачного рынка Казахстана преобладает IaaS (более чем на 70%), в то время в России, большую долю занимает SaaS. Объяснения такого тренда очевидны — Казахстан отстает в своем технологическом развитии от северного соседа.

Противоречия на этом не заканчиваются. Казалось бы, что при вложении столь солидных инвестиций, решение о строительстве ЦОД должно быть взвешенным. Проанализировав собственный опыт взаимодействия с заказчиками в проектах строительства датацентров, мы сделали заключение:

Большинство будущих владельцев ЦОД регулярно наступают на одни и те же грабли.

В этой статье мы собрали наиболее часто встречающиеся заблуждения и попробовали обосновать каждое из них.

Бизнес может быть любым, при строгом соблюдении единственного простого условия — он должен быть прибыльным. И противоречие здесь заключается в том, что большинство будущих владельцев ЦОД расценивают прибыль как некий само-собой разумеющийся факт, который будет оставаться на стабильном уровне в течение всего будущего периода эксплуатации ЦОД. Я вполне допускаю роскошь такого образа мышления, если не принимать во внимание нарастающую конкуренцию. Опыт развитых стран ясно показывает, что участвовать в жесткой конкурентной борьбе, в конечном счете, приходится и государственным компаниям. Вывод — будущие владельцы датацентров должны думать над снижением себестоимости услуг коммерческих ЦОД уже на стадии их планирования.

Итак, если вы — будущий облачный провайдер и планируете строительство ЦОД, то вам будет полезно руководствоваться следующими критериями.

Выгоднее использовать высокоплотные стойки

Плотность мощности ИТ-стоек во многом влияет на выбор инженерной инфраструктуры, например, на планировку, архитектуру охлаждения или распределения питания. Если операторы значительно недооценивают плотность, на объекте могут возникнуть проблемы с развертыванием новейших ИТ-систем или закончится электроэнергия до того, как машинный зал будет заполнен.

Плотность напрямую влияет на значение коэффициента PUE — чем эффективнее объект по своей конструкции, тем выше вероятность, что он будет иметь более высокую модальную среднюю плотность мощности. Это объясняется тем, что крупные центры обработки данных, как правило, более новые и лучше оптимизированы с точки зрения эффективности

В центрах обработки данных с годовым показателем PUE выше 1,6 преобладают стойки с относительно низкой плотностью мощности 5кВт и ниже. В ЦОД с PUE в диапазоне от 1,3 до 1,6 преобладают стойки мощностью от 5 до 10кВт. И, почти каждый шестой в этой группе с более низким показателем PUE использует стойки мощностью 10кВт и выше в качестве стандартной практики.

Выгоднее строить отказоустойчивые ЦОДы

В последние годы в ИТ-индустрии сложилось следующее мнение: облачные вычисления (частные или публичные) изменят ИТ-индустрию таким образом, что вычислительные мощности будут иметь высокий уровень гибкости и смогут автоматически перенаправляться от неисправной площадки к исправной. По этой причине, сама инфраструктура отдельного ЦОД не обязана быть такой же устойчивой, как раньше.

Но существует и противоположное мнение: на сегодняшний день в центрах обработки данных выполняются все более критичные вычисления, и ПО, контролирующие эту работу, не всегда прозрачно и весьма сложно, и может быть подвержено ошибкам конфигурации. Более того, любые отказы крупных компонентов могут спровоцировать каскадный эффект, делая восстановление после аварии очень трудным и дорогостоящим. По этой причине важно иметь хорошую отказоустойчивость инфраструктуры.

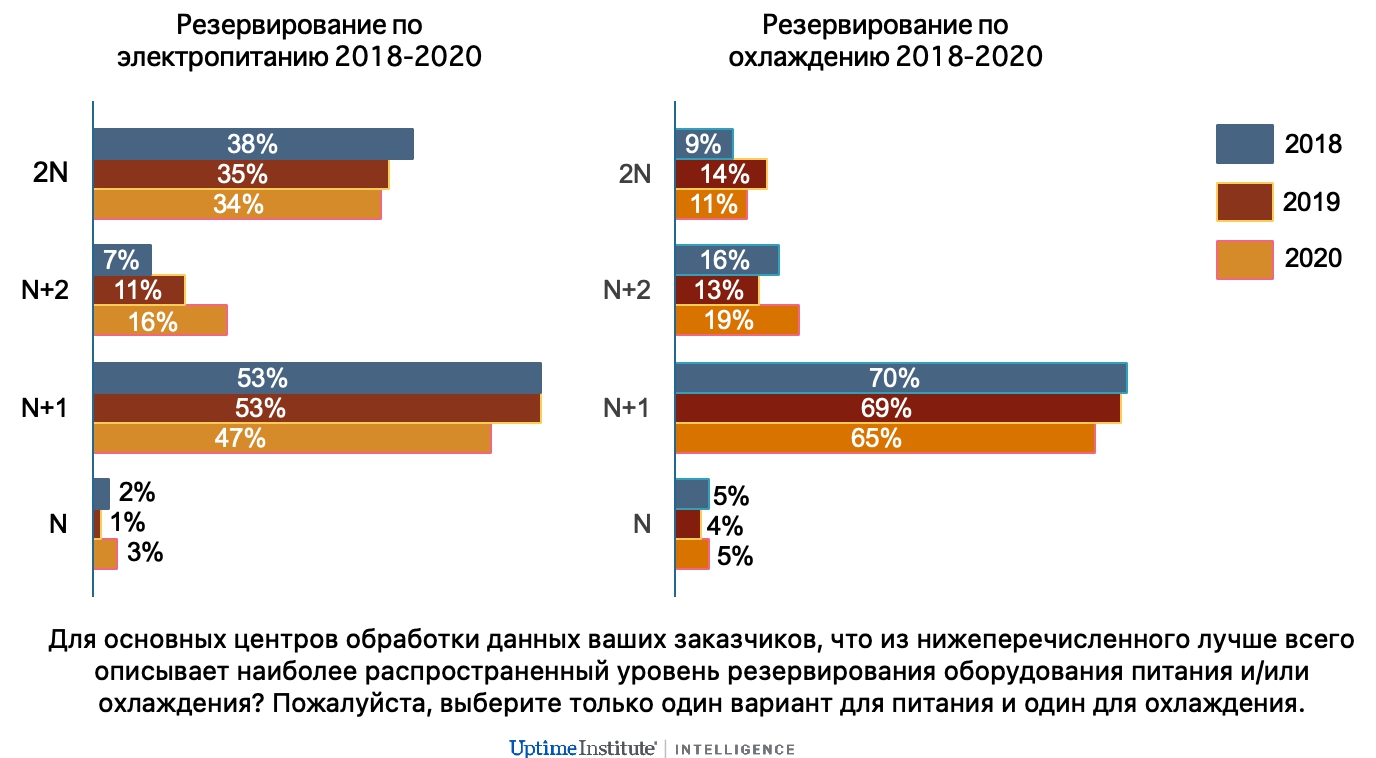

Последний аргумент выигрывает. В то время, как поставщики и проектировщики наблюдают незначительное уменьшение числа центров обработки данных с уровнем резервирования 2N, в последние три года также виден устойчивый тренд перехода резервирования с N+1 на N+2. Причем это касается не только систем энергоснабжения, но и систем охлаждения.

Выгоднее строить большие ЦОДы

Помимо связи между плотностью серверных стоек и значением коэффициента PUE, Uptime Institute также выявил связь между плотностью электропитания, размером и эффективностью центра обработки данных.

На объектах с максимальной ИТ-нагрузкой более 3-х МВт (мегаватт) наблюдается сдвиг в сторону более мощных серверных стоек, от 5 до 10 кВт в сравнении с небольшими объектами. Плотность размещения стоек, как правило, еще выше в центрах обработки данных мощностью более 5-ти МВт.

Другой сдвиг происходит в самых крупных объектах, свыше 30-ти МВт: стойки в диапазоне 10-20 кВт встречаются гораздо чаще, чем стойки мощностью менее 5-ти кВт. Вероятное объяснение заключается в том, что объекты такого масштаба, как правило, обслуживают облачные и интернет-компании (будь то собственная площадка или арендованный ЦОД), которые обычно предпочитают шкафы, полностью укомплектованные высокопроизводительными ИТ.

На прошедшей в октябре этого года онлайн-конференции «ЦОД — шелковый путь» было озвучено несколько интересных аналитических выводов.

Один из них звучит следующим образом:

Чем меньше ЦОД, тем срок его окупаемости дольше. Следовательно, дольше срок возврата инвестиций и меньше финансовая эффективность.

В качестве подтверждения, аналитик IKS Media привела изменения параметров эффективности инвестиционного проекта с учетом ключевых параметров проекта по строительству ЦОД.

С ростом количества серверных стоек в вашем будущем датацентре, вы не только сокращаете инвестиции из расчета на одну стойку, но и можете расчитывать на бо’льшую выручку (ежемесячно в среднем на 25% больше). И срок окупаемости проекта, при этом, сократится на несколько лет.

Разумеется, предлагая инвестору подобные привлекательные финансовые показатели, нельзя упускать из внимания, что эти условия сработают, если ваш ЦОД будет отвечать всем современным требованиям отказоустойчивости (уровень отказоустойчивости не менее Tier III), а также при условии использования серверных стоек с большой плотностью (от 5кВт и выше). Поэтому, все вышеуказанные критерии можно легко сформулировать в виде одного комплексного критерия:

Выгоднее строить большие энергоэффективные ЦОДы с уровнем отказоустойчивости Tier III и большим количеством высокоплотных стоек.

Какой вывод может сделать для себя будущий владелец ЦОД? Один из основных путей снижения себестоимости услуг облачных провайдеров — повышение энергоэффективности своих ЦОДов. Повышать энергоэффективность — значит использовать высокоплотные стойки, полностью укомплектованные высокопроизводительными ИТ. Повышение плотности ИТ-стоек, как правило, возможно в большей степени именно в одном большом датацентре, чем в нескольких маленьких.

Говоря об энергоэффективности, нельзя не учитывать и последующие операционные расходы. В большей степени — расходы на электроэнергию.

Если в России еще рассчитывают CAPEX на стойку, то в мире уже рассчитывают CAPEX на киловатт или мегаватт.

Возникает резонный вопрос: «где же та золотая середина в соотношении CAPEX и OPEX? Как узнать — сможет ли будущий владелец найти достаточное количество клиентов, которые согласятся установить свои серверы в высокоплотные стойки в его коммерческом ЦОД?»

Разумеется, однозначного ответа здесь быть не может. Успех и достижение стратегических целей в любом бизнесе зависит от эффективной и успешной работы различных взаимодействующих друг с другом бизнес-подразделений: от маркетинга до финансов, от логистики до внешних партнеров и поставщиков.

Многолетний опыт компании Vicom Plus в сфере строительства инженерных инфраструктур для центров обработки данных значительно помогает будущим владельцам коммерческих ЦОД в принятии правильных стратегических решений.

Это стало возможным благодаря тому, что мы разработали четкую методологию консультационных услуг, основанных как на казахстанских реалиях, так и на мировом опыте проектирования и строительства ЦОД.